Қўшимча функционаллар

-

Тунги кўриниш

Deepfake технологияси: «синтетик медиа»нинг келажаги қандай?

Бир неча ой муқаддам Жанубий Кореяда яшовчи миллионлаб томошабинлар кундалик янгиликларни томоша қилиш учун МBN каналига юзланишади.

Ҳар оқшомдаги каби экранда сухандон Ким Жу-Ха пайдо бўлади ва у одамларни янгиликлардан бохабар қилишга киришади. 2020 йилги кун тартибига мувофиқ, янгиликларнинг аксарияти Covid-19 эпидемияси ва унга қарши кураш ҳақида эди.

Аммо шунга қарамай, ушбу ахборот кўрсатуви одатдагидан мутлақо бошқача эди, чунки экрандаги инсон, аслида, Ким Жу-Ха эмасди. Унинг ўрнига ушбу сухандоннинг deepfake технологияси билан яратилган версияси янгиликларни ўқиб эшиттираётган эди. Компьютер технологияси ёрдамида ишлаб чиқарилган «сохта» сухандон овоз, мимика ва табассумларни мукаммал тарзда такрорлаётганди.

Томошабинлар аввалроқ ушбу шоу ҳақида огоҳлантирилганди. Кейинги тадқиқотлар шуни кўрсатадики, тингловчилар бу ҳолга нисбатан турлича муносабат билдиришган. Баъзилар чиндан ҳам ҳайратда эканини, баъзилар эса ҳақиқий Ким Жу-Ханинг ишдан айрилиб қолишидан хавотирланаётганини таъкидлайди.

МBN канали баъзи тезкор янгиликларда deepfake технологиясидан фойдаланишда давом этишини маълум қилди. Ушбу технологияни ишлаб чиқарувчиларидан бири – Жанубий Кореянинг Moneybrain компанияси янги шериклик имкониятлари учун Хитой ва АҚШ билан алоқалар ўрнатилишини эълон қилди.

Deepfake технологияси деганда, одатда, кўпчиликнинг ақлига машҳур инсонлар ҳақидаги видеолар келади. Ўтган ҳафта Том Крузнинг муносабати акс этган сохта видео ТikTok иловасига жойлаштирилганидан сўнг бутун дунё диққат-эътиборини жалб қилди.

Умумий фойдаланишда бўлган deepfake технологияси эътирозларга қарамай (одамлар ёлғон билан тўқнаш келишни исташмайди), тижорий мақсадлар йўлида тобора кўпроқ қўлланмоқда.

«Бу – контент яратишнинг келажаги»

Сектор тилида «сунъий интеллект ёрдамида ишлаб чиқарилувчи видеолар» ёки «синтетик медиа» деб номланувчи ушбу технология янгиликлар, кўнгил очиш ва таълим соҳаларида катта қизиқиш уйғотмоқда. Албатта, бунга мазкур технологиянинг кундан кунга ривожланиб бораётгани ҳам ўз таъсирини ўтказмоқда.

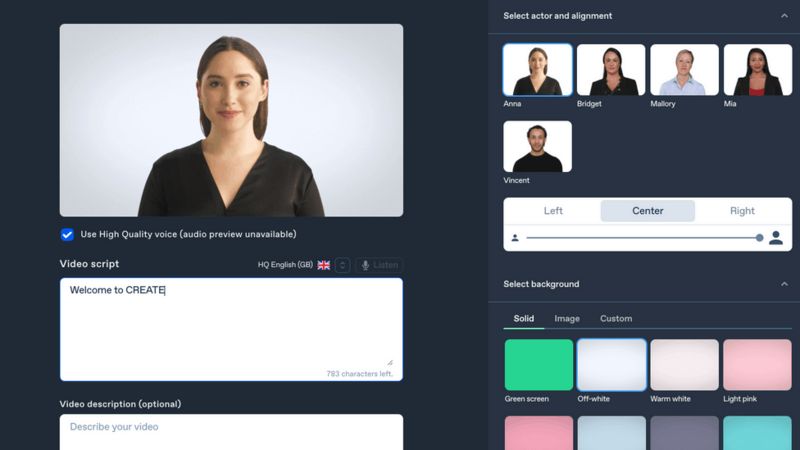

Лондондаги Synthesia компанияси ушбу технологияни фирманинг ички ўқув видеоларида фойдаланиш учун сотмоқда.

«Бу – контент яратишнинг келажагидир», дейди фирма асосчиларидан бири Виктор Рипарбелли.

Synthesia тизимида турли аватар вариантлар мавжуд бўлиб, етказилмоқчи бўлган хабар ёзилса, уларнинг жавобини олиш мумкин.

Рипарбеллининг таъкидлашича, шу тариқа глобал компаниялар таълим жараёнида фойдаланиш учун турли тиллардаги видеоларни жуда осонлик билан тайёрлашлари мумкин.

«Айтайлик, Шимолий Америкада омборда ишловчи 3 минг нафар ишчингиз бор. Уларнинг баъзилари инглиз тилида гаплашади, баъзилари эса испан тилини яхши билишади. Агар улар билан ахборот алмашмоқчи бўлсангиз, тўрт саҳифадан иборат pdf маълумотни уларнинг олдига қўйишнинг ўзи етарли бўлмайди. Бундай вазиятда инглиз ва испан тилларидаги 3 дақиқалик видеоролик нисбатан самарали бўлиши мумкин.

Агар сиз ўша видеоларнинг ҳар бирини суратга олишга мажбур бўлсангиз, бу ҳам иқтисодий жиҳатдан қимматга тушади, ҳам бажариладиган иш ҳажми нуқтайи назардан кўп меҳнатни талаб қилади. Энди биз буни кам харажат эвазига, матн ёзиш учун талаб қилинадиган вақт давомида бажариш имкониятига эгамиз. Бу – бугунги кунда технологиядан қандай фойдаланилаётганининг ёрқин мисоли бўла олади», дейди у.

Бироқ, Veritone сунъий интеллект технологиялари компанияси менежери Чад Стилбергнинг таъкидлашича, deepfake’дан ёмон ниятда фойдаланиш билан боғлиқ хавотирлар ундан қонуний фойдаланиш учун сармоя киритмоқчи бўлган компанияларни ортга қадам ташлашга мажбур қилмоқда.

«Биз ҳолат компания ва инвесторларнинг ушбу технологияга «ёпишиб» олишларига тўсқинлик қилаётган бўлса-да, мазкур технологияга қизиқиш ортиши натижасида бу кайфият ўзгариб бормоқда», дейди Стилберг deepfake’нинг инвестиция соҳасида оқсаётганига изоҳ берар экан.

Бошқа бир сунъий интеллект технологиялари фирмаси – Modulate директори Майк Папас ҳам deepfake ва у билан боғлиқ этик қоидалар бўйича қизғин баҳслар бўлаётгани ва одамлар бу ҳақда бош қотиришда давом этаётганини таъкидлайди.

Папаснинг айтишича, технологиядан фойдаланишнинг этик жиҳатлари бўйича тадқиқотлар ортиб бориши билан инвесторларнинг ишончи ҳам ортмоқда.

«Deepfake: нима қилиш керак?»

Deepfake технологиясига ихтисослашган юридик фанлар профессори Лилиан Эдвардс эса масаланинг бошқа бир муҳим жиҳати – видеоларга бўлган ҳуқуқлар кимга тегишли эканига эътибор қаратади.

Эдвардс бу борадаги фикрини қуйидагича ифода этади: «Агар бундай видеода актёр Стив Маккуин ёки реп юлдузи Тупакдан мана шундай бир видеода фойдаланилса, у ҳолда оила ундан даромад олишга ҳақлими ёки йўқ? Бу борадаги мунозаралар давом этмоқда. Фикрлар эса турли мамлакатда турлича».

Виржиния университетининг этика профессори Дебора Жонсон яқинда «Deepfake: нима қилиш керак?» номли китоб ёзди. Унинг фикрича, deepfake – бу институтлар ва визуал тажрибаларга бўлган ишончни камайтирувчи, шунингдек, «нотўғри маълумот тарқатиш» муаммосининг бир қисмидир.

Биз энди кўрган ва эшитган нарсаларимизга ишонмаймиз», дейди Дебора Жонсон. Унинг фикрича, deepfake технологиясидан фойдаланган ҳолда яратилган видеоларни эълон қилишдан олдин улар сохта экани айтилиши лозим. Бу билан томошабинларни ҳимоя қилиш мумкин.

Оксфорд университети профессори Сандра Вахтер ҳам deepfake технологияси тобора ривожланиб бораётганини таъкидлади: «Агар сиз ўтган ҳафта Том Круз видеосини томоша қилган бўлсангиз, ушбу технологиянинг қанчалик ривожланганини кўришингиз мумкин. Бу тўрт йил олдинги Обаманинг видеосига қараганда анча реалроқ эди. Биз ушбу технологиядан кўп ҳам қўрқмаслигимиз ва унга мутаносиб равишда ёндашишимиз керак. Ҳа, ёмон ва хавфли нарсаларга қарши турувчи қонунлар бўлиши лозим. Аммо ҳажв ёки сўз эркинлиги доирасида яратилган deepfake видеоларга қатъиян тақиқ қўймаслигимиз даркор.

Сунъий интеллектга асосланган видеолардан таълим мақсадида фойдаланилишига оид мисоллардан бири Калифорния университети Геноцид фонди томонидан келтирилди.

Геноциддан омон қолган 55 мингдан зиёд кишининг гувоҳлигини тақдим этган мазкур фонд меҳмонлар ва геноциддан омон қолганларни deepfake технологияси ёрдамида бирлаштиради.

«Далилларнинг ўлчами» деб номланган мазкур лойиҳада меҳмонлар томонидан берилган саволларга геноциддан омон қолган ва илгари интервью олинган инсонларнинг тезкор жавоб бериши таъминланади.

Veritone менежери Чад Стилбергнинг таъкидлашича, келажакда ушбу технологиядан фойдаланган ҳолда авлодлар аввал яшаб ўтган ўз аждодлари билан суҳбатлашишлари мумкин.

«Жамият нуқтайи назардан олиб қараганда, бу инқилобий характега эга», дейди Стилберг.